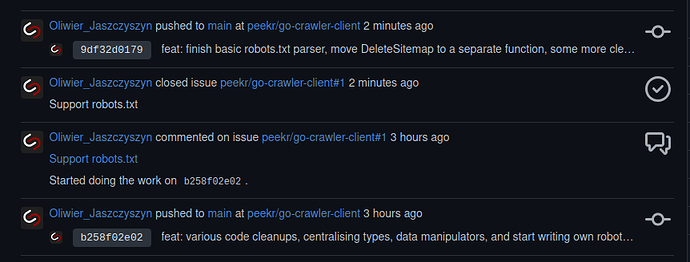

Tym razem zabrałem się za robots.txt – niby niepozorny plik, ale bardzo ważny wśród crawlerów. Parser tego pliku jest przepisany od nowa, myślę, że trochę lepiej spełnia swoje zadanie, niż jego odpowiednik w Pythonie.

1 Like

Jak przechowujesz dane o zebranych danych z robots.txt?

Sam plik robots.txt jest przetwarzany w locie – jedyne, co jest z nich zapisywane, to nowe mapy stron w XMLu.

1 Like